脳内映像

2018年04月10日 [色々なこと]

お疲れ様です。院長です。

4月10日の火曜日でございます。

4月も気付けば1/3終わったわけですが、まだまだこれからが春ですよ。

今日は朝から快晴で暖かいですから、まさに春爛漫って感じだね。

これからドンドン気温が上がって薄着になっていきますから、ダイエットするなら、もう始めないと間に合いませんぜ(笑)

夏まで後、ちょうど100日くらいです。

頑張るならそろそろですよ〜。

って、このままダイエットネタでもいくのかと思わせておいて、全然違う方向に(笑)

今日のネタは、最新AI情報をブッこんでみたいと思います。

人間は思考します。

そして、思考と態度、表情などバラバラに表現できる数少ない生物です。

つまり、心では怒ってるのに、表情は笑うとかその逆とか…

「こころを読む」なんて言葉がありますが、今日はそんなことができてしまうAIのお話となってます。

カナダの心理学者によってちょっと怖いマシンが開発されました。

人が誰かの顔を目にした時に生じる、脳の電気信号から、心に描かれているものを再現するというなかなかな内容のマシンでございます。

カナダ、トロント大学スカボロ校では、被験者に顔の画像を提示しながら、脳波測定(EEG)キャップを用いてその脳活動を記録し、得られた情報を基にソフトウェアで脳内の顔の再現をするという実験を試みました。

実験の鍵を握ったのは、脳の機能をシミュレートして学習するニューラルネットワークです。

このニューラルネットワークてのは、脳機能に見られるいくつかの特性を計算機上のシミュレーションによって表現することを目指した数学モデルってことで、詳しくはwikiで勉強して下さればいいですが、簡単に言えば脳内のものを映像化するってニュアンスで大丈夫でございます。

これは訓練を通じて情報(音声、テキストデータ、視覚イメージなど)に含まれるパターンを認識することが可能で、近年のAIの発展における要となってるんですね。

今回の研究では、まず膨大な画像データベースから、顔のパターン認識学習が実施されました。

そして、AIが人間の顔を構成する特徴を認識できるようになった時点で、今度はそれと脳波パターンを関連付けられるよう訓練していくと…

このデータと被験者の脳活動を合致させることで、AIは彼らが目にしているものを再現できるようになるわけです。

まぁ、色々細かい事はありますけど、基本、AIってヤツはとにかくデータを与えれば与えるほど、精度が上がります。

あらゆるパターンを覚え込ませることで、こういう事も可能になるんでしょうねぇ…。

例えば、人間でも学習していけば100人や200人の顔と、例えば名前や、体格、声なんかは関連付けて覚えられます。

ま、最近の院長は、覚えるより忘れるスピードがぶっちぎりで、もうすぐデータが消失しようかとしておりますが…。

で、話を戻して、このAIの精度は驚くべきもので、視覚的なディテールを精細に描くことができるようになったわけです。

つまり、人が心に思い浮かべた内容を忠実に映像化出来るようになったってことなんですよ。

AIの処理能力を駆使すればこんなことも出来るってことなんでしょうねぇ…。

このAIに関しては、本当に進化が目覚ましく、そのうちほんまに人間を越えてくるでしょう。

今回のマシンは、頭に描いたものを映像化するってことですから、使い道としては例えば言語能力に障害がある場合、つまり話せない人でも、頭に思い描くことが映像化されることによって、対話出来るようになるんじゃないかとか。

または、もっと高度な障害で、植物状態の患者さんでも、脳内に何かを思い浮かべられるなら、その他の臓器がすべて活動停止していても、その人の考えが映像化できるとか…。

雑念ばかりの場合、脳内を映像化なんかされた日にゃ、とんでもないことが起こりそうですが、これからの研究でさらに精度や安全性が向上していくことでしょう。

考えてることが言葉に出さずとも、相手に映像として見えるなんて、もう言葉以上のコミュニケーションが取れる可能性もありますしね。

一昔前の漫画なんかで、よく死んだ人の「脳」だけを保存して生き返らせるなんてのがありましたけど、この機械があればそんな「脳」とも「会話」できる可能性も出てきますからね…。

もしほんとにそうなったら、いわゆる「死」の定義すら変わる可能性が出てくるんだよね。

もともと、ヒトの「死」って少〜し曖昧なとこがあって、基本は「死の三兆候」ってので決めてるんですがこれは「自発呼吸の停止」「心拍の停止」「瞳孔散大」の三つで、いわゆる「脳死」ってのはまた別なんですね。

では、「脳死」ってどういう定義かと言うとこれはあくまでも「臓器移植法」における定義付けであり、そもそもの「死」ではなかったりするんですよ。

で、「臓器移植法」における脳死の定義は、「大脳および脳幹(中脳、橋、延髄)の不可逆的な停止」ってことになってます。

でも、この時点(脳死判定)でも、人工呼吸器で呼吸はあったりするんですよね。

なので、これからの一つの問題として、今まで「脳死」としてきた状態で、もし今日紹介したマシンなどが、その死んだ「脳」から映像などを出力できたら、もうこれはその「脳」からの意思表示となってしまうでしょ?

で、ここで臓器移植について、移植の意思があるかを確認することが出来るっちゃ出来ますがこうなると、「死」と呼べるのか?ってなりません?

とか…

まぁ、またもや脱線しましたが、「新しいこと」が始まると、やはりなにかしらの問題は起こるもんで、そういうイレギュラーを繰り返し、AIも成長していくんですけどね…。

我々人間の頭脳だけでは、イレギュラーはイレギュラーとして処理されますが、AIの場合、2回目からはもはや、学習済みとしてイレギュラーでもなんでもなくなりますから…

もう、だいぶついて行けてない院長ですが、世の中はドンドン進化していってるわけですから…

少しはついてく努力しないとね〜

ではまた〜

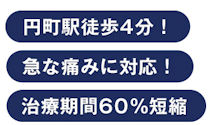

京都 中京区 円町 弘泉堂鍼灸接骨院

4月10日の火曜日でございます。

4月も気付けば1/3終わったわけですが、まだまだこれからが春ですよ。

今日は朝から快晴で暖かいですから、まさに春爛漫って感じだね。

これからドンドン気温が上がって薄着になっていきますから、ダイエットするなら、もう始めないと間に合いませんぜ(笑)

夏まで後、ちょうど100日くらいです。

頑張るならそろそろですよ〜。

って、このままダイエットネタでもいくのかと思わせておいて、全然違う方向に(笑)

今日のネタは、最新AI情報をブッこんでみたいと思います。

人間は思考します。

そして、思考と態度、表情などバラバラに表現できる数少ない生物です。

つまり、心では怒ってるのに、表情は笑うとかその逆とか…

「こころを読む」なんて言葉がありますが、今日はそんなことができてしまうAIのお話となってます。

カナダの心理学者によってちょっと怖いマシンが開発されました。

人が誰かの顔を目にした時に生じる、脳の電気信号から、心に描かれているものを再現するというなかなかな内容のマシンでございます。

カナダ、トロント大学スカボロ校では、被験者に顔の画像を提示しながら、脳波測定(EEG)キャップを用いてその脳活動を記録し、得られた情報を基にソフトウェアで脳内の顔の再現をするという実験を試みました。

実験の鍵を握ったのは、脳の機能をシミュレートして学習するニューラルネットワークです。

このニューラルネットワークてのは、脳機能に見られるいくつかの特性を計算機上のシミュレーションによって表現することを目指した数学モデルってことで、詳しくはwikiで勉強して下さればいいですが、簡単に言えば脳内のものを映像化するってニュアンスで大丈夫でございます。

これは訓練を通じて情報(音声、テキストデータ、視覚イメージなど)に含まれるパターンを認識することが可能で、近年のAIの発展における要となってるんですね。

今回の研究では、まず膨大な画像データベースから、顔のパターン認識学習が実施されました。

そして、AIが人間の顔を構成する特徴を認識できるようになった時点で、今度はそれと脳波パターンを関連付けられるよう訓練していくと…

このデータと被験者の脳活動を合致させることで、AIは彼らが目にしているものを再現できるようになるわけです。

まぁ、色々細かい事はありますけど、基本、AIってヤツはとにかくデータを与えれば与えるほど、精度が上がります。

あらゆるパターンを覚え込ませることで、こういう事も可能になるんでしょうねぇ…。

例えば、人間でも学習していけば100人や200人の顔と、例えば名前や、体格、声なんかは関連付けて覚えられます。

ま、最近の院長は、覚えるより忘れるスピードがぶっちぎりで、もうすぐデータが消失しようかとしておりますが…。

で、話を戻して、このAIの精度は驚くべきもので、視覚的なディテールを精細に描くことができるようになったわけです。

つまり、人が心に思い浮かべた内容を忠実に映像化出来るようになったってことなんですよ。

AIの処理能力を駆使すればこんなことも出来るってことなんでしょうねぇ…。

このAIに関しては、本当に進化が目覚ましく、そのうちほんまに人間を越えてくるでしょう。

今回のマシンは、頭に描いたものを映像化するってことですから、使い道としては例えば言語能力に障害がある場合、つまり話せない人でも、頭に思い描くことが映像化されることによって、対話出来るようになるんじゃないかとか。

または、もっと高度な障害で、植物状態の患者さんでも、脳内に何かを思い浮かべられるなら、その他の臓器がすべて活動停止していても、その人の考えが映像化できるとか…。

雑念ばかりの場合、脳内を映像化なんかされた日にゃ、とんでもないことが起こりそうですが、これからの研究でさらに精度や安全性が向上していくことでしょう。

考えてることが言葉に出さずとも、相手に映像として見えるなんて、もう言葉以上のコミュニケーションが取れる可能性もありますしね。

一昔前の漫画なんかで、よく死んだ人の「脳」だけを保存して生き返らせるなんてのがありましたけど、この機械があればそんな「脳」とも「会話」できる可能性も出てきますからね…。

もしほんとにそうなったら、いわゆる「死」の定義すら変わる可能性が出てくるんだよね。

もともと、ヒトの「死」って少〜し曖昧なとこがあって、基本は「死の三兆候」ってので決めてるんですがこれは「自発呼吸の停止」「心拍の停止」「瞳孔散大」の三つで、いわゆる「脳死」ってのはまた別なんですね。

では、「脳死」ってどういう定義かと言うとこれはあくまでも「臓器移植法」における定義付けであり、そもそもの「死」ではなかったりするんですよ。

で、「臓器移植法」における脳死の定義は、「大脳および脳幹(中脳、橋、延髄)の不可逆的な停止」ってことになってます。

でも、この時点(脳死判定)でも、人工呼吸器で呼吸はあったりするんですよね。

なので、これからの一つの問題として、今まで「脳死」としてきた状態で、もし今日紹介したマシンなどが、その死んだ「脳」から映像などを出力できたら、もうこれはその「脳」からの意思表示となってしまうでしょ?

で、ここで臓器移植について、移植の意思があるかを確認することが出来るっちゃ出来ますがこうなると、「死」と呼べるのか?ってなりません?

とか…

まぁ、またもや脱線しましたが、「新しいこと」が始まると、やはりなにかしらの問題は起こるもんで、そういうイレギュラーを繰り返し、AIも成長していくんですけどね…。

我々人間の頭脳だけでは、イレギュラーはイレギュラーとして処理されますが、AIの場合、2回目からはもはや、学習済みとしてイレギュラーでもなんでもなくなりますから…

もう、だいぶついて行けてない院長ですが、世の中はドンドン進化していってるわけですから…

少しはついてく努力しないとね〜

ではまた〜

京都 中京区 円町 弘泉堂鍼灸接骨院