チャットボットとニュース

2025年03月31日 [色々なこと]

お疲れ様です。院長です。

3月31日の月曜日でございます。

なんでも今日は「オーケストラの日」だそうですよ。

では元気にネタいきましょう。

生成AIの一種、チャットボットは、メールやコードの作成、プログラミングや事務処理など、多くの作業を効率化する便利なツールです。

ですが、このAIがニュースを正確に伝えられるかという点では、まだ課題が多いんだそうです。

「AIは無限の可能性を秘めていますが、誤った情報を広めるリスクもあります。」と、英BBCニュース・時事部門のCEO、デボラ・ターネス氏は、自社が行った調査結果を受けてこう警鐘を鳴らしました。

調査対象となったのはOpenAIの「ChatGPT」、Microsoftの「Copilot」、Googleの「Gemini」、Perplexity AIの「Perplexity」の4種です。

いずれも有名なチャットボットですが、それらが手がけたニュースの要約の半数以上に、事実や数字の誤りなど、重大な欠陥が見受けられたそうです。

今回の調査では、ニュース記事100件を要約してもらい、それについて専門知識があるジャーナリストに内容を評価してもらいました。

すると要約の実にに51%のに重大な問題があることが明らかになったそうです。

またAIが引用したBBCニュースの19%で、事実・数字・日付などの間違いが発見されました。

そうした間違いは、たとえば次のようなものでした。

・英国国民保険サービスは禁煙の補助的な手段として電子タバコを推奨していない(実際はしている/Geminiの回答)

・リシ・スナク(英国の元首相)とニコラ・スタージョン(英スコットランド行政府の元首相)は在職中である(実際は辞任している/ChatGPTとCopilotの回答)

・イランは自制的な態度で、イスラエルは攻撃的な行動をとった(PerplexityがBBCニュースの引用として回答したもの。実際のニュースはこのように伝えていない)

AIチャットボットの要約は誤った事実を伝えるばかりでなく、意見と事実の区別ができず、勝手に編集を行い、しばしば必要な文脈も説明されていなかったそうです。

さらに全体的に見ると、ChatGPTやPerplexityに比べると、CopilotとGeminiの方がより重大な欠陥を抱えている傾向にあったそうです。

因みにわたくし院長は、ChatGPTをよく使わせてもらってます。

AIがしれっと嘘をつくことは以前から知られていましたが、こうした現象を「ハルシネーション(幻覚)」というそうです。

ハルシネーションが起きる原因の1つは、AIの知性と私たちの知性とが根本的に異なっていることであるようです。

シンシナティ大学のアンソニー・チェメロ教授が2023年に語ったところによると、高度な知能を持つといわれるAIは、そもそも言葉を理解していないそうです。

統計的に次に来る可能性が高い言葉を羅列しているだけで、それが正しいかどうかなど気にもしないんだとか…。

また、2025年、スペインのバレンシア人工知能研究所のホセ・エルナンデス・オロヤ教授がWSJに語ったところによると、ハルシネーションが起きる理由は、AIの設計に問題があるそうです。

AIは「必ず何か答えること」を目標にして作られており、知らないことでも推測して答えを出すことで精度を向上させるように設計されています。

それっぽいことを答えなければ正解の確率がゼロになるため、間違っていてもそれっぽい答えを出してしまうそうなんです。

今回の調査では、こうした機械のたわごとが最新のAIでも消えていないことが証明されてしまったわけです。

BBCニュースのデボラ・ターネスCEOはブログで、AIには「無限の可能性」がある一方、これを開発する企業は「火遊びをしている」ようなものと述べています。

彼女が懸念するのは、こうしたAIによる虚偽情報が、現実世界に大きな被害をもたらすという可能性です。

それゆえに、AIによる要約記事を削除するべきだと訴えています。

実は以前、AppleのAI「Apple Intelligence」が表示するニュースの内容が不正確であるとして、BBCがその掲載をやめさせたことがあるそうです。

その一方で、BBCはAI企業と協力する方法も模索してもいます。

同社はこれまでも「AI企業との新たな対話のきっかけ」を探してきたとのこと。

今回AIの問題点が明らかになったわけですが、それでもメディアとAI企業は一丸となって解決策を探せるはずだと、ターネスCEOと述べてます。

まぁ、まだまだこれからの分野でしょ。

こういうことをキッカケにドンドン精度が上がればそれでいいと思いいますけどね。

問題なしです。

ではまた〜。

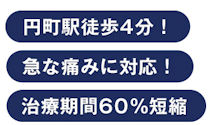

京都 中京区 円町 弘泉堂鍼灸接骨院

3月31日の月曜日でございます。

なんでも今日は「オーケストラの日」だそうですよ。

では元気にネタいきましょう。

生成AIの一種、チャットボットは、メールやコードの作成、プログラミングや事務処理など、多くの作業を効率化する便利なツールです。

ですが、このAIがニュースを正確に伝えられるかという点では、まだ課題が多いんだそうです。

「AIは無限の可能性を秘めていますが、誤った情報を広めるリスクもあります。」と、英BBCニュース・時事部門のCEO、デボラ・ターネス氏は、自社が行った調査結果を受けてこう警鐘を鳴らしました。

調査対象となったのはOpenAIの「ChatGPT」、Microsoftの「Copilot」、Googleの「Gemini」、Perplexity AIの「Perplexity」の4種です。

いずれも有名なチャットボットですが、それらが手がけたニュースの要約の半数以上に、事実や数字の誤りなど、重大な欠陥が見受けられたそうです。

今回の調査では、ニュース記事100件を要約してもらい、それについて専門知識があるジャーナリストに内容を評価してもらいました。

すると要約の実にに51%のに重大な問題があることが明らかになったそうです。

またAIが引用したBBCニュースの19%で、事実・数字・日付などの間違いが発見されました。

そうした間違いは、たとえば次のようなものでした。

・英国国民保険サービスは禁煙の補助的な手段として電子タバコを推奨していない(実際はしている/Geminiの回答)

・リシ・スナク(英国の元首相)とニコラ・スタージョン(英スコットランド行政府の元首相)は在職中である(実際は辞任している/ChatGPTとCopilotの回答)

・イランは自制的な態度で、イスラエルは攻撃的な行動をとった(PerplexityがBBCニュースの引用として回答したもの。実際のニュースはこのように伝えていない)

AIチャットボットの要約は誤った事実を伝えるばかりでなく、意見と事実の区別ができず、勝手に編集を行い、しばしば必要な文脈も説明されていなかったそうです。

さらに全体的に見ると、ChatGPTやPerplexityに比べると、CopilotとGeminiの方がより重大な欠陥を抱えている傾向にあったそうです。

因みにわたくし院長は、ChatGPTをよく使わせてもらってます。

AIがしれっと嘘をつくことは以前から知られていましたが、こうした現象を「ハルシネーション(幻覚)」というそうです。

ハルシネーションが起きる原因の1つは、AIの知性と私たちの知性とが根本的に異なっていることであるようです。

シンシナティ大学のアンソニー・チェメロ教授が2023年に語ったところによると、高度な知能を持つといわれるAIは、そもそも言葉を理解していないそうです。

統計的に次に来る可能性が高い言葉を羅列しているだけで、それが正しいかどうかなど気にもしないんだとか…。

また、2025年、スペインのバレンシア人工知能研究所のホセ・エルナンデス・オロヤ教授がWSJに語ったところによると、ハルシネーションが起きる理由は、AIの設計に問題があるそうです。

AIは「必ず何か答えること」を目標にして作られており、知らないことでも推測して答えを出すことで精度を向上させるように設計されています。

それっぽいことを答えなければ正解の確率がゼロになるため、間違っていてもそれっぽい答えを出してしまうそうなんです。

今回の調査では、こうした機械のたわごとが最新のAIでも消えていないことが証明されてしまったわけです。

BBCニュースのデボラ・ターネスCEOはブログで、AIには「無限の可能性」がある一方、これを開発する企業は「火遊びをしている」ようなものと述べています。

彼女が懸念するのは、こうしたAIによる虚偽情報が、現実世界に大きな被害をもたらすという可能性です。

それゆえに、AIによる要約記事を削除するべきだと訴えています。

実は以前、AppleのAI「Apple Intelligence」が表示するニュースの内容が不正確であるとして、BBCがその掲載をやめさせたことがあるそうです。

その一方で、BBCはAI企業と協力する方法も模索してもいます。

同社はこれまでも「AI企業との新たな対話のきっかけ」を探してきたとのこと。

今回AIの問題点が明らかになったわけですが、それでもメディアとAI企業は一丸となって解決策を探せるはずだと、ターネスCEOと述べてます。

まぁ、まだまだこれからの分野でしょ。

こういうことをキッカケにドンドン精度が上がればそれでいいと思いいますけどね。

問題なしです。

ではまた〜。

京都 中京区 円町 弘泉堂鍼灸接骨院